В современном телепроизводстве аудио существует в двух формах: вложенное (embedded) и независимое. В рабочих процессах часто смешивают оба варианта: вложенный звук в видеосигналах и отдельный звук для чисто аудиоустройств. При переходе индустрии на IP-инфраструктуру обе модели остаются актуальными, и отрасль должна поддерживать каждую из них.

Вложенное аудио

При использовании вложенного аудио звук передается внутри интерфейса SDI (Serial Digital Interface). В SDI аудио физически размещается в области вспомогательных данных (ANC) видеосигнала. С точки зрения маршрутизации, управления, синхронизации и задержек (A/V alignment) - это простая модель. IP-расширением этой модели является стандарт SMPTE ST 2022-6, где звук встроен в видео, и весь поток передается через IP.

AES67

Исторически существовало множество различных стандартов для реализации передачи аудио через IP (AoIP). Наиболее известными из них являются Ravenna, Dante, LiveWire, Q-LAN, WheatNet-IP и AVB.

Несмотря на сходство, каждый из этих стандартов имеет свои особенности. Чтобы улучшить совместимость оборудования в индустрии, общество AES разработало AES67 - "Стандарт AES для аудиоприложений в сетях: высокопроизводительная совместимость потокового аудио через IP". Впервые он был опубликован в 2013 году.

На верхнем уровне AES67 формирует IP-пакеты протокола RTP (Real-Time Transport Protocol), содержащие аудиосэмплы PCM (импульсно-кодовая модуляция). Дополнительные заголовки или избыточные данные отсутствуют. AES67 передает аудиоканалы через IP в виде отдельных потоков, которые можно независимо маршрутизировать внутри сетевой инфраструктуры.

Ключевые компоненты AES67 включают в себя:

- Синхронизация (Synchronization) - обеспечивает точное совпадение времени между устройствами в сети (обычно используется протокол PTPv2).

- Транспорт (Transport)- определяет способ передачи данных по сети (используется протокол UDP).

- Инкапсуляция и стриминг (Encapsulation and streaming) - правила упаковки аудиоданных в пакеты и их последовательной отправки.

- Описание сессий (Session description) - набор данных о формате потока (частота дискретизации, количество каналов и т.д.), необходимых принимающему устройству.

Синхронизация в AES67

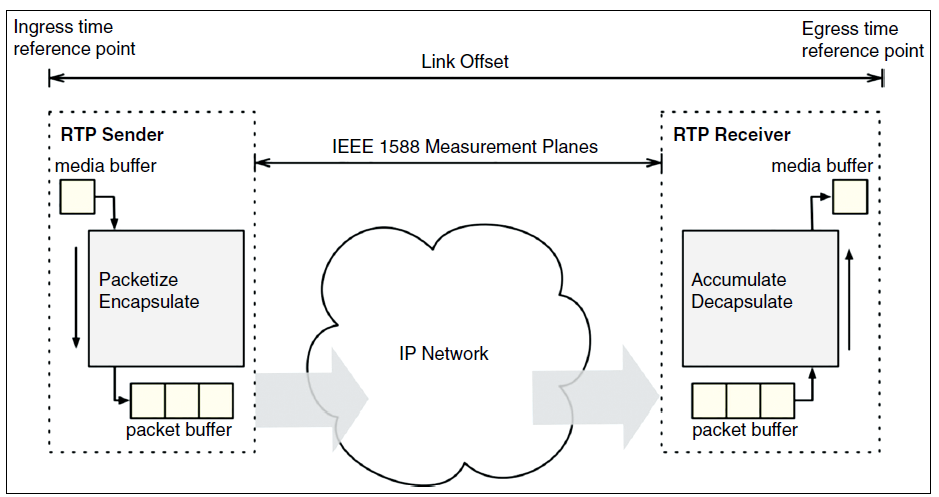

Синхронизация между всеми передатчиками и приемниками AES67 осуществляется с помощью протокола точного времени IEEE 1588-2008 (PTP). PTP распределяет точное время по сети IP на все устройства. Используя это время, передатчики и приемники формируют синхронизированные media clocks, которые используются для дискретизации входящего аудио и создания временных меток (timestamps) RTP.

Гибкость стандарта PTP позволяет использовать "профили" для различных отраслей и задач. Профили ограничивают такие параметры, как частота отправки сообщений о времени. AES67 поддерживает как стандартный профиль IEEE (по умолчанию), так и специальный профиль AES67.

Поскольку все устройства AES67 в сети синхронизированы между собой, преобразование частоты дискретизации (SRC) между ними не требуется. SRC может понадобиться только для входных сигналов, которые не привязаны к общему тактовому генератору сети.

Транспорт в AES67

Транспорт описывает, каким образом закодированные медиаданные передаются по сети. В AES67 передача осуществляется с помощью протоколов RTP поверх UDP поверх IPv4.

Стандарт допускает использование как одноадресной (unicast), так и многоадресной (multicast) передачи. Однако для профессионального вещательного рынка основным режимом является многоадресная рассылка. Для передачи аудиоданных и сообщений PTP в режиме multicast устройства AES67 обязаны поддерживать протокол IGMPv2 и могут поддерживать IGMPv3.

Инкапсуляция и стриминг в AES67

Пакеты AES67 создаются путем последовательного объединения аудиосэмплов PCM. Стандарт поддерживает следующие параметры:

- Частота дискретизации: 44.1, 48 и 96 кГц.

- Разрядность: 16 бит (L16) и 24 бита (L24).

Пакеты AES67 отправляются с постоянным временным интервалом, который называется временем пакета (packet time). AES67 определяет диапазон таких интервалов, рекомендуемые значения: 125 мкс, 250 мкс, 333 мкс, 1 мс и 4 мс. Допускаются и другие значения.

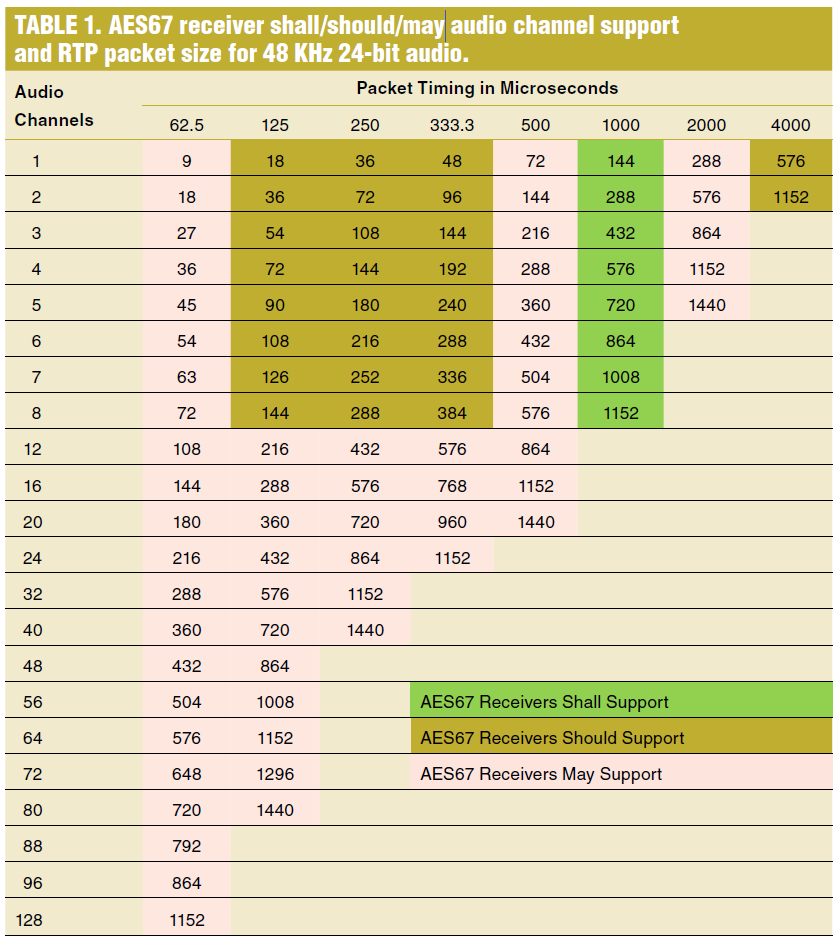

Количество аудиоканалов в одном потоке ограничено максимальным размером сетевого пакета (MTU), частотой дискретизации, разрядностью и временным интервалом. Примеры ограничений (при MTU = 1500):

- 80 каналов при интервале 125 мкс, L24, 48 кГц.

- 10 каналов при интервале 1 мс, L24, 48 кГц.

Поскольку диапазон параметров AES67 очень широк, количество их комбинаций огромно. Многие из них не имеют смысла для большинства задач. Чтобы обеспечить совместимость, стандарт определяет обязательный набор параметров, который должны поддерживать все передатчики и приемники.

Для аудио 48 кГц L24 большинство сценариев использования покрывается следующим обязательным набором:

- Частота дискретизации: 48 кГц.

- Разрядность: 16 бит (L16) и 24 бита (L24).

- Интервал пакета: 1 мс.

- Количество каналов: от 1 до 8.

Описание сессий в AES67 (Session Description)

Чтобы приемник мог декодировать поток, ему необходима информация о его параметрах: количестве аудиоканалов, разрядности и источнике синхронизации. Поскольку в AES67 нет дополнительных заголовков или внутриполосных данных (in-band information), эти сведения передаются приемнику через протокол описания сессий (SDP), согласно RFC 4566.

AES67 определяет поля внутри SDP, однако стандарт не устанавливает строгий способ распространения этой информации по системе. Это обеспечивает гибкость на будущее, но также создает некоторые проблемы с совместимостью.

SDP - это текстовый формат, пригодный для чтения как машиной, так и человеком, хотя для людей он выглядит довольно зашифрованным. Ниже приведен пример фрагмента SDP с пояснениями:

v=0- Версия протокола (например, 0).c=IN IP4 239.1.1.2/32- Данные о соединении: IP-адрес239.1.1.2и TTL (время жизни пакета) - 32.t=0 0- Время активности сессии (начало и окончание). Нулевые значения означают отсутствие временных ограничений.m=audio 5004 RTP/AVP 96- Описание медиапотока: аудио по протоколу RTP на порту 5004 с динамическим payload type 96.i=Channels 1-8- Текстовое описание сессии: каналы с 1 по 8.a=rtpmap:97 L24/48000/6- Сопоставление RTP-типа 97 с форматом: 24-битная глубина, частота дискретизации 48 кГц, 6 аудиоканалов.a=ptime:0.250- Длительность аудиопакета - 0.250 мс (интервал между отправкой пакетов).a=ts-refclk:ptp=IEEE1588-2008:39-A7-94-FFFE-07-A7-E0:0- Источник временной синхронизации: стандарт IEEE1588-2008 (PTP), идентификатор ведущего устройства (Grandmaster) и домен 0.a=mediaclk:direct=113224434- Смещение между RTP timestamp и медиа-временем: значение 113224434 соответствует моменту начала отсчёта медиа-клока.

AES67 для раздельной маршрутизации аудио (Breakaway) в телепроизводстве

В современных традиционных системах (baseband) раздельная маршрутизация аудио позволяет пользователям направлять звуковые каналы по отдельности (моно) или стереопарами, в зависимости от задачи. Аудиоканалы также могут быть логически сгруппированы и переключаться большими группами, сохраняя при этом синхронизацию между каналами на уровне сэмплов.

Чтобы реализовать такой же функционал в AES67, пакеты данных должны быть ограничены одним или двумя аудиоканалами, так как пакетный поток является минимальной единицей маршрутизации в IP-сети. Хотя AES67 позволяет передавать больше каналов в одном пакете, их увеличение ограничит минимальную единицу маршрутизации (вы не сможете направить один канал из пакета в одну сторону, а второй - в другую).

Единственные недостатки использования одного или двух каналов в пакете:

- Незначительное увеличение объема служебных данных (

overhead). - Необходимость настройки дополнительных IP-адресов многоадресной рассылки (

multicast). - Увеличение времени переключения при одновременной коммутации большого количества потоков.

Управление AES67

Существует три аспекта управления потоками AES67:

- Обнаружение и регистрация (Discovery and registration): процесс поиска передатчиков, приемников и потоков в системе управления.

- Маршрутизация (Routing): процесс направления потоков от передатчиков к приемникам. Это также называют управлением соединениями (connection management).

- Передача данных SDP: предоставление приемникам информации о параметрах потока (SDP).

Стандарт AES67 предлагает несколько вариантов реализации этих задач, но не закрепляет какой-то один метод как обязательный. Это привело к определенным проблемам с совместимостью оборудования разных брендов.

Для решения этой проблемы ассоциация AMWA разработала спецификацию NMOS IS-04 (Discovery and Registration). Она стандартизирует процесс обнаружения и регистрации, причем IS-04 позволяет управлять не только аудио, но также видеопотоками и метаданными.

AES67 совместно с ST 2022-6

Стандарт SMPTE ST 2022-6 ("Транспортировка медиасигналов с высокой скоростью передачи данных по IP-сетям") определяет правила передачи несжатого видео SD и HD через IP. Этот стандарт берёт все сэмплы SDI, организует их в группы по 1376 октетов и упаковывает в IP-пакеты.

Если в потоке SDI есть вложенное аудио, ST 2022-6 передаёт его по IP вместе с видеосигналом. Для задач, требующих независимой маршрутизации звука (breakaway), может использоваться комбинация: AES67 для аудио и ST 2022-6 для видео. При этом аудиопоток AES67 может быть как извлечён из SDI (de-embedded), так и взят из дискретного источника.

Этот метод приводит к некоторому дублированию полосы пропускания, так как в ряде случаев звук передаётся дважды: один раз внутри видеопотока, а второй - отдельно.

Синхронизация и тайминг между ST 2022-6 и AES67

Стандарт ST 2022-6 не требует обязательной синхронизации видеопотока с общестудийной системой Genlock. В то же время AES67 требует, чтобы все устройства были синхронизированы с ведущим генератором PTP (PTP Master).

Следовательно, хотя вложенное аудио остаётся синхронизированным внутри потока SDI, извлечённое (de-embedded) аудио обычно должно быть синхронизировано с опорным сигналом. Для этого оно проходит через преобразователь частоты дискретизации (SRC), чтобы перейти из тактового домена видеосигнала в тактовый домен PTP. То же самое применимо и в обратном случае: когда аудио AES67 вкладывается обратно в асинхронный поток SDI.

Синхронизация звука и видео (A/V Alignment)

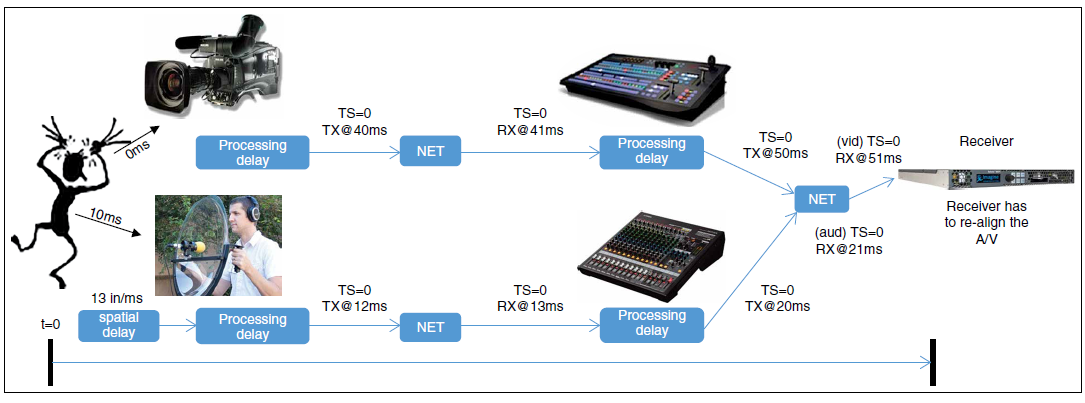

Поскольку аудио и видео передаются отдельными потоками с разными задержками, необходимо использовать специальные методы для их выравнивания, чтобы избежать рассинхронизации звука и картинки (lip sync). Разница в задержках возникает из-за того, что сигналы проходят через разные сетевые узлы и процессы обработки. Техническая рекомендация VSF TR-04 описывает метод совместного использования потоков ST 2022-6 и TR-03 для решения этой проблемы.

В обычном стандарте ST 2022-6 временная метка RTP (timestamp) ни к чему не привязана. Рекомендация TR-04 накладывает ограничение: метка RTP в ST 2022-6 должна быть жёстко синхронизирована с PTP. Таким образом, она формируется по методу, аналогичному временным меткам в AES67.

Используя метку RTP в AES67, приёмник может воспроизводить аудио с фиксированной задержкой относительно момента его создания. Точно так же, благодаря TR-04, приёмник работает с видеопотоком. Установив одинаковое значение задержки для обоих типов данных (при условии, что изначально они были синхронны), приёмник выдаёт идеально выровненный сигнал.

Дополнительные возможности

Использование таких меток позволяет реализовать и другие функции. Например, для микрофона на схеме Рис. 1 можно скорректировать временную метку аудио, чтобы компенсировать задержку прохождения звука по воздуху от объекта до мембраны. Если для каждого микрофона на стадионе задать индивидуальную корректировку, все аудио- и видеоканалы будут идеально синхронизированы в одной точке времени.

VSF TR04

AES67 как часть VSF TR-03 (и ST 2110)

Техническая рекомендация VSF TR-03 ("Транспортировка несжатых элементарных потоков медиаданных по IP") определяет метод передачи видео, аудио и вспомогательных данных (ANC) в виде отдельных сущностей через IP. На основе TR-03 организация SMPTE разработала стандарт ST 2110. Для передачи видео в TR-03 используется протокол RFC 4175, а для передачи PCM-аудио - AES67.

VSF TR-03 (включающий аудио AES67) отличается от VSF TR-04 (ST 2022-6 плюс аудио AES67) следующим:

-

Отсутствие дублирования аудио. В модели

TR-03звук передаётся только в отдельном аудиопотокеAES67. Избыточного дублирования звука (как внутри видеопотока, так и отдельно) не происходит. -

Отсутствие вложенного аудио. В

TR-03нет концепции вложенного (embedded) аудио. Чтобы получить звук, приёмник обязан «подписаться» на отдельные аудиопотокиAES67.

Синхронизация и тайминг в VSF TR-03

Потоки VSF TR-03 в обязательном порядке должны быть синхронизированы с ведущим генератором PTP (PTP Master). В сети может быть несколько независимых PTP-мастеров - например, при приёме асинхронных сигналов извне. Проверяя поле PTP-мастера в файле SDP, приёмник может определить, какие аудио- и видеопотоки привязаны к одному и тому же источнику синхронизации.

- Потоки от одного мастера

- Преобразование частоты дискретизации (SRC) не требуется. Это стандартный сценарий работы студии.

- Потоки от разных мастеров

- Требуются аудио-SRC и видеосинхронизаторы кадров (frame syncs).

Выравнивание аудио и видео в VSF TR-03

Стандарт VSF TR-03 требует, чтобы временная метка RTP для видео была жёстко привязана к опорному сигналу PTP. Благодаря этому для выравнивания потоков в TR-03 применяются те же методы, что и в VSF TR-04 (см. Рис. 2).

VSF TR-03 (SMPTE ST 2110)

AES67 и система синхронизации SMPTE ST 2059 (Genlock)

Для перехода от традиционных систем синхронизации (Analog Black Burst + DARS + LTC) к сетевому IP-таймингу организация SMPTE разработала семейство стандартов ST 2059. Эти стандарты базируются на протоколе IEEE 1588 PTP.

-

ST 2059-1определяет правила генерации синхронизированных сигналов на основе времени (относительно эпохи SMPTE). -

ST 2059-2определяет конкретный профиль PTP для использования в профессиональном вещании.

Эволюция стандартов передачи аудио по IP

Технические рекомендации VSF TR-03 и TR-04 преобразуются в полноценные стандарты через семейство ST 2110. ST 2110 во многом опирается на TR-03 и TR-04, дополняя и улучшая их содержание. После публикации ST 2110 рекомендации TR-03 и TR-04 будут считаться устаревшими.

AES67 - это гибкий стандарт. SMPTE ST 2110 использует AES67, но накладывает на него определённые ограничения, актуальные для профессиональной медиаиндустрии, и группирует дополнительные функции AES67 в уровни соответствия (conformance levels).

-

Все приёмники, совместимые с

AES67, должны соответствоватьST 2110-30Уровень A. -

Передатчики

AES67, соблюдающие ограниченияST 2110, также будут совместимы сST 2110-30.

По своей структуре AES67 поддерживает только несжатое аудио (PCM). Следовательно, его нельзя использовать для сжатого звука или задач, требующих передачи битов C (Channel Status) и U (User data) из сигнала AES3. Чтобы обеспечить прозрачную передачу потоков AES3, разрабатывается стандарт ST 2110-31.

Заключение

Независимое аудио (или раздельная маршрутизация SDI-аудио) является стандартным элементом современного процесса телепроизводства. Эту функциональность необходимо реализовать и в IP-среде по мере того, как индустрия отходит от интерфейса SDI. Существующий стандарт AES67 для передачи аудио через IP полностью отвечает этим требованиям для PCM-звука.

AES67 может использоваться как совместно с ST 2022-6, так и с VSF TR-03. Сочетание этих стандартов с ST 2059 и VSF TR-04 формирует полноценное решение для поддержания синхронизации аудио и видео на всех этапах производственного цикла.

После публикации семейство стандартов SMPTE ST 2110 заменит собой рекомендации VSF TR-03 и TR-04. При этом AES67 останется ключевым компонентом стандарта ST 2110.